近年来,AI技术推动了许多行业的发展,呈现出"万物皆可AI"的景象。从消费级的电子数码产品,到to B端的驾驶、安防、教育等等,AI的概念已辐射到各行各业,在我们的生活中不断"抢戏"。就连许多高规格的国际会议上,AI同传的身影也开始频频亮相。

当嘉宾在台上讲话时,随着演讲的声音,由AI同传翻译的中英文双语字幕,同步呈现在旁边大屏幕之上,满满的都是科技范。不过,传统的机器同传只能获取语音信息,在识别专业术语时难以理解演讲语境,在面对同音词、语气词等复杂情况时,翻译效果不够理想。

如何进一步提高AI同传的识别和翻译能力?近日,搜狗给我们带来了新的答案。

2019年12月21日,在极客公园创新大会上,搜狗发布了业内首个具备多模态认知能力的同传系统——搜狗同传3.0。与常规算法升级不同,搜狗同传3.0第一次引入了"语境引擎",结合视觉识别技术与知识谱图,将AI同传的准确性提升到了一个新的高度。

想要让AI理解人类的自然语言,其实背后是一个统计学的技术问题。我们输入足够的数据构建起机器模型,就让AI逐渐理解并学习当前场景的语义内容。人工同传在进行同传翻译前,往往会花大量时间进行准备,掌握所译领域的术语词汇和表达方式。倘若能让AI如同人类译员一样理解所译领域的内容方向,无疑会带来准确率的显著提升。

搜狗同传3.0所独创的"语境引擎",除了让AI"能听"还能同时做到"边看边思考"。从官方资料来看,它是通过OCR(光学字符识别)技术获取演讲内容自动生成核心知识,并利用「搜狗知立方」知识图谱实时推理拓展,充分扩展演讲的背景知识与词库,对内容进行个性化加强。另外,同传系统可以基于搜狗百科的中英术语库获得中英双语对照,实时优化同传识别和翻译的效果。

也就是说,搜狗同传3.0从单一的语音识别+机器翻译,进化到了看懂画面文本+理解语义语境+推理扩展词库的多种交互方式,几乎接近了人类译员的工作模式。

最近几年,搜狗一直用各种与AI相关的"黑科技",在我们的视线中刷屏。其实,一直坚持以语言为核心的AI布局,搜狗在多模态领域的探索和应用早已有之。此前推出的AI合成主播,就运用了语音、唇语、表情动作等交互形式,栩栩如生的AI合成主播参与到了2019年两会、春运、315晚会等报道,还远赴海外推出了全球首个俄语AI合成主播和阿拉伯语AI合成主播。

扫描画面得到文字信息的OCR技术,在之前搜狗翻译与vivo NEX3手机的合作中,翻译聚合App里的图片翻译,就可以提供 AR实景翻译和菜单翻译功能,受到了很多用户的欢迎。"搜狗知立方"通过整合海量的互联网碎片化信息,以"语义理解"为方向对搜索结果进行重新优化计算,让AI理解用户搜索意图和问题,直接为用户提供想要的答案。同样,此前上线的搜狗英文垂直频道,引入微软必应的全球搜索技术,对接全球范围内多达万亿的英文信息,构成了搜狗同传3.0中丰富的英文词库信息。

可以说,本次推出的搜狗同传3.0,并非是一蹴而就的概念产品。它聚合了多种交互形式实现同传的协作能力,乃是搜狗多年深耕AI技术后积累的成果,也为AI同传的行业发展提供了方向。

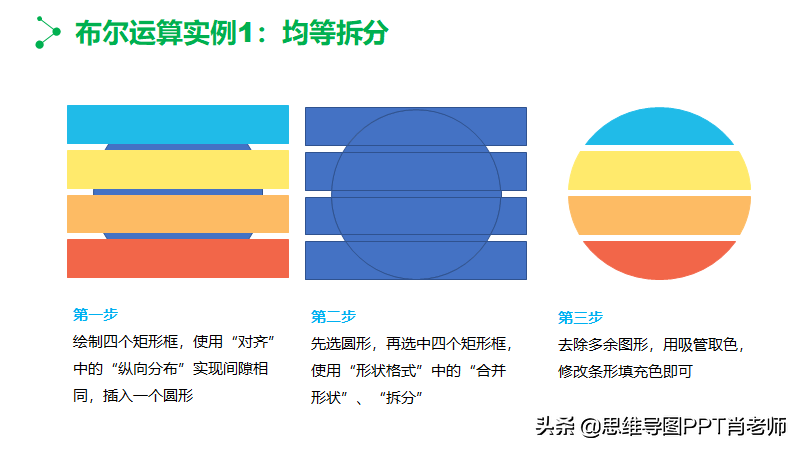

相比于人工准备资料极大的局限性,AI能整合更加丰富的资料,获得更高的翻译质量,也极大提高了AI同传的泛化能力。据公开资料显示,搜狗同传3.0针对PPT内容的识别准确率提升21.7%,翻译正确率提升40.3%。

说了这么多,我们的视线再拉回到行业与未来。AI同传的发展,并非是要取代人工同传,而是会构成一个有效补充的角色,让同传变成一项"普惠服务"。比如,在一些因同传费用太高或没有相关领域同传译员的会议,可以借助AI同传来满足翻译需求。或者在普通人出国旅游的时候,AI同传可以胜任很多时候的翻译职能,让我们在餐厅、机场、车站等环境里不再尴尬。

当未来多模态同传技术普及以后,我们的社会生活还能发生怎样的改变?不同语种间的人们,彼此戴着一个蓝牙耳机,AI就能完成对话时的无缝连接。把那些科幻电影里的画面变成现实,这才是未来科技该有的模样。